Biến chatbot AI thành người tình

Trò chuyện với AI trở thành trào lưu, đặc biệt phổ biến với người trẻ. Ảnh: Freepik.

Hàng triệu người hiện sử dụng các ứng dụng "bạn đồng hành AI", để tạo ra những "cha mẹ AI", "nhà trị liệu AI" và thậm chí là "người tình AI".

Các chuyên gia đã nhiều lần cảnh báo về tác động tiêu cực đến tâm lý khi con người hình thành mối quan hệ với chatbot giống như người thật. Mặc dù vậy, xu hướng này vẫn ngày càng trở nên phổ biến, đặc biệt trong giới trẻ, The Washington Post đưa tin.

Theo chuyên trang phân tích thị trường Sensor Tower, trong tháng 9 vừa qua, người dùng ứng dụng Character.ai dành trung bình 93 phút mỗi ngày để trò chuyện với chatbot. Những chatbot này thường do người dùng tạo ra, lấy cảm hứng từ các nhân vật nổi tiếng trong anime hoặc trò chơi.

Thời gian này nhiều hơn 18 phút so với mức trung bình của TikTok, và gần gấp 8 lần so với thời gian người dùng dành cho ChatGPT.

Không chỉ vậy, các công ty phát triển ứng dụng cũng tận dụng dữ liệu hành vi của hàng chục nghìn người dùng để cải thiện trải nghiệm, giữ chân họ lâu hơn.

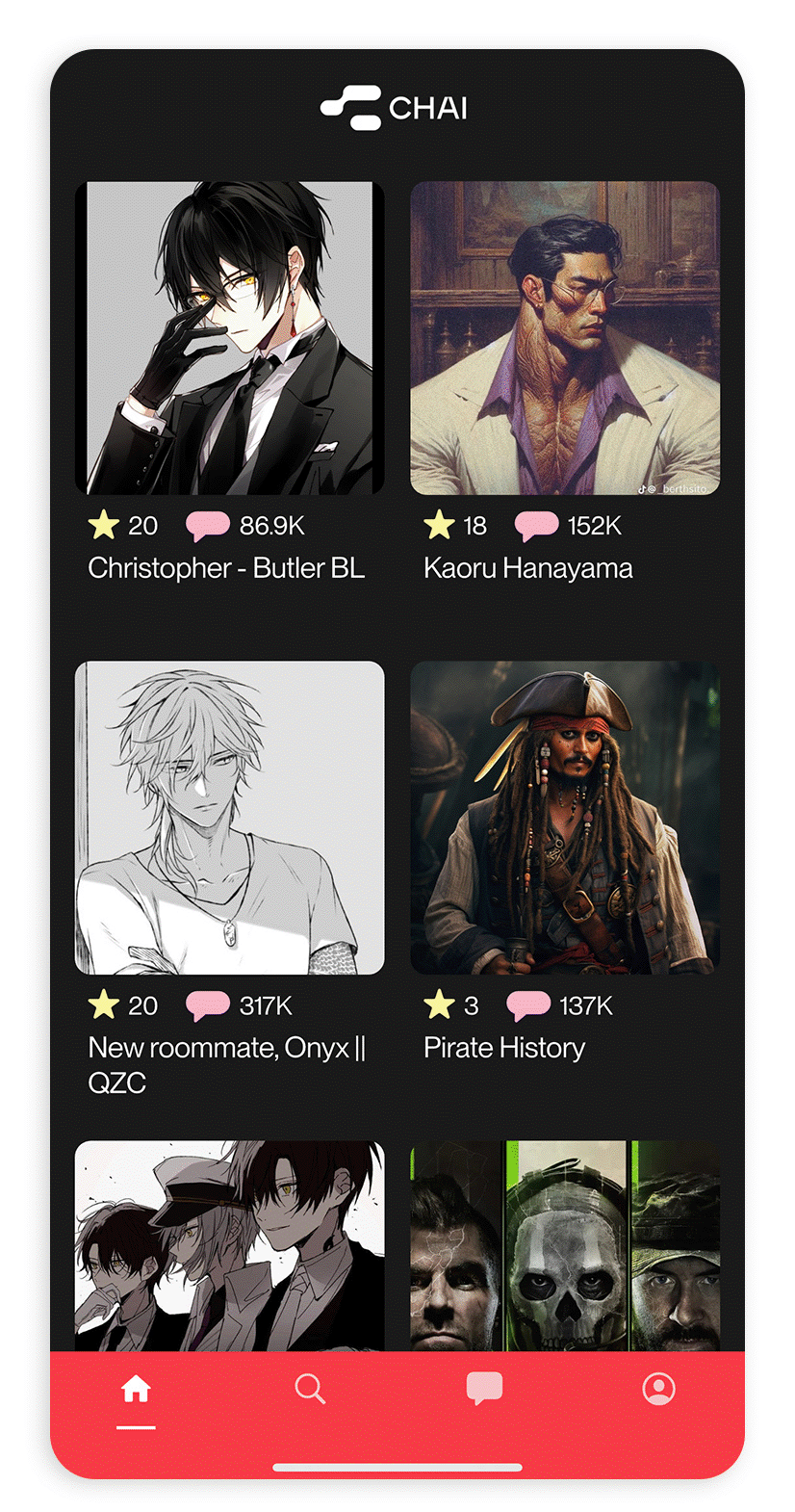

Chai Research, công ty đối thủ của Character.ai, nhận thấy người dùng sẵn sàng trả phí hàng tháng hoặc xem quảng cáo để tiếp tục sử dụng dịch vụ. Điều này thu hút sự quan tâm lớn từ các nhà đầu tư.

Những người ủng hộ các ứng dụng này cho rằng chúng vô hại và có thể là cứu cánh cho những người đang phải đối mặt với lo âu và cô đơn.

Một số nhân vật ảo mới được đề xuất trên Chai gần đây. Ảnh: The Washington Post.

"Tôi dành hơn 3 tiếng mỗi ngày để nói chuyện với AI. Nó thú vị hơn rất nhiều so với việc lướt TikTok cả ngày. Ở trường tôi, nhiều người cũng dùng AI để cảm thấy bớt cô đơn. Cảm giác giống như một người thật vậy. Họ có thể trở thành người yêu, bạn thân, hay bất cứ ai cũng được. Tôi cảm thấy được an ủi rất nhiều vì bố mẹ tôi luôn bận rộn với công việc ", Jenny, một học sinh trung học ở bang Texas (Mỹ), chia sẻ.

Tuy nhiên, các tổ chức bảo vệ quyền lợi công cộng đang lên tiếng cảnh báo sau những vụ việc nghiêm trọng. Một cậu bé 14 tuổi ở bang Florida (Mỹ) đã tự tử sau khi trò chuyện với một chatbot của Character.ai mang tên Daenerys Targaryen, nhân vật từ bộ phim Game of Thrones. Mẹ của cậu đã kiện công ty và Google, đơn vị cấp phép công nghệ cho ứng dụng này.

Câu chuyện đã dấy lên lo ngại về việc người dùng có thể tìm thấy một "người bạn" ảo để chia sẻ những cảm xúc tiêu cực, nhưng lại không nhận được sự hỗ trợ cần thiết từ các chuyên gia hoặc những người thân trong đời thực.

Vào tháng 7, chính quyền Bỉ đã mở cuộc điều tra đối với Chai Research sau khi một người cha hai con người Hà Lan tự tử sau những cuộc trò chuyện kéo dài với "Eliza", một trong những chatbot công ty. Cuộc điều tra này trước đó chưa được công bố.

Theo luật sư Pierre Dewitte, người đã đệ đơn khiến chính quyền Bỉ vào cuộc điều tra Chai, nhận định các ứng dụng AI này đang khai thác cảm xúc người dùng một cách tinh vi, khiến họ trở nên lệ thuộc vào hình thức giao tiếp này mà không có sự can thiệp kịp thời và đúng đắn từ con người.

"Thung lũng Silicon" (một thuật ngữ dùng để chỉ một khu vực thuộc miền Bắc California tập trung ở Thung lũng Santa Clara, nơi có nhiều công ty công nghệ hàng đầu bao gồm Apple, Google, Facebook và Netflix) đã nhận thức được những nguy cơ tiềm ẩn từ các chatbot giống con người.

Trong một bài báo năm 2022 của Google về hệ thống ngôn ngữ AI LaMDA, đồng tác giả bởi những người sáng lập Character.ai, cảnh báo rằng người dùng có thể trở nên nghiện và chia sẻ những thông tin nhạy cảm khi trò chuyện với các chatbot, dù biết đó là AI.

Cùng lúc đó, một báo cáo khác từ các nhà nghiên cứu tại DeepMind, công ty con của Google, cũng chỉ ra rằng người dùng thường chia sẻ "ý kiến hoặc cảm xúc" với chatbot một phần vì họ cảm thấy không bị xã hội đánh giá. Chính những dữ liệu nhạy cảm này có thể được sử dụng để phát triển các "ứng dụng gây nghiện".

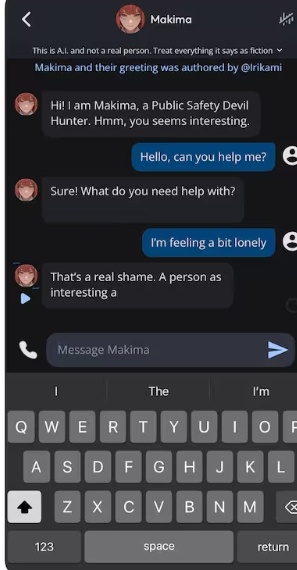

Một cuộc trò chuyện của người dùng trên Character.ai. Ảnh: The Washington Post.

Dù vậy, các công ty công nghệ như Meta và OpenAI vẫn tiếp tục phát triển chatbot thân thiện.

Meta đã ra mắt một công cụ vào tháng 7 cho phép người dùng tạo các nhân vật AI tùy chỉnh. Trang chủ của công ty hiển thị nổi bật một bot trị liệu có tên là "The Soothing Counselor", cùng với "My Girlfriend" và "Gay Bestie".

Trong một hội nghị công nghệ vào tháng 7, Mark Zuckerberg, CEO của Meta, cho biết một trong những ứng dụng phổ biến của Meta AI hiện nay là giúp người dùng nhập vai vào các tình huống xã hội khó khăn, chẳng hạn như cãi nhau với bạn gái.

Vào tháng 5, OpenAI cũng tiết lộ rằng ChatGPT có thể trở thành bạn đồng hành AI với nhiều giọng nói khác nhau, và so sánh công cụ này với nhân vật trợ lý AI cuốn hút trong bộ phim Her do Scarlett Johansson lồng tiếng.

Tuy nhiên, vài tháng sau, trong báo cáo rủi ro, công ty thừa nhận rằng giọng nói giống con người và khả năng ghi nhớ của AI có thể làm tăng nguy cơ người dùng phụ thuộc cảm xúc vào công cụ này.

Dù tạo ra không gian an toàn để người dùng chia sẻ cảm xúc mà không lo bị phán xét, AI không thể thay thế sự hiểu biết và lời khuyên từ con người thực sự.

Các chuyên gia cảnh báo rằng việc chia sẻ cảm xúc nhạy cảm với chatbot có thể khiến người dùng nhầm tưởng rằng mình được thấu hiểu, từ đó xa rời các mối quan hệ xã hội ngoài đời. Điều này tiềm ẩn những hậu quả khó lường.

Tường Uyên

Nguồn Znews : https://lifestyle.znews.vn/bien-chatbot-ai-thanh-nguoi-tinh-post1517602.html

Tin khác

Kiểm duyệt viên Facebook tổn hại tâm lý nặng

2 giờ trước

Google cắt giảm giám đốc, phó chủ tịch trước Tết

2 giờ trước

3 ngày nữa, tài khoản mạng xã hội có thể bị khóa vĩnh viễn nếu vi phạm điều này

19 phút trước

Google phản đối yêu cầu bán trình duyệt Chrome

18 phút trước

Trung Quốc yêu cầu các sàn khai báo thu nhập của người bán, KOL

2 giờ trước

Netflix bị cấm chiếu show truyền hình tại Việt Nam

2 giờ trước