Big Tech và startup đang chạy đua thiết kế loại chip mới giải quyết vấn đề ngốn năng lượng của AI

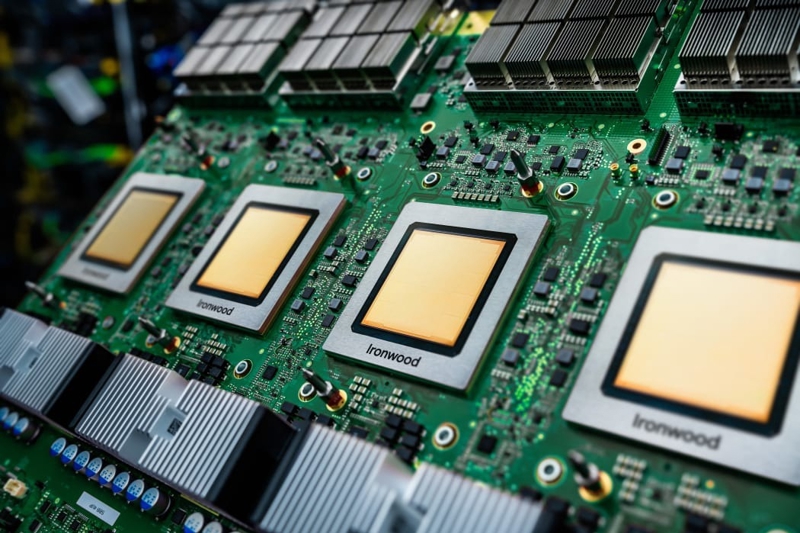

Google phát triển chip AI của riêng mình và phát hành chip Ironwood vào năm 2025

Các siêu máy tính AI trong tương lai được dự đoán sẽ tiêu thụ một lượng năng lượng khổng lồ. Những cỗ máy này được kỳ vọng sẽ thúc đẩy bước nhảy vọt của nhân loại trong lĩnh vực trí tuệ nhân tạo.

Từng giữ các vai trò cấp cao tại Apple và Meta, hiện là Giám đốc phần cứng của nhà cung cấp dịch vụ đám mây Cloudflare, Andrew Wee cũng là một chuyên gia kỳ cựu 30 năm trong lĩnh vực trung tâm dữ liệu và phần cứng tại Thung lũng Silicon. Ông cho rằng tốc độ tăng trưởng năng lượng hiện nay của AI – được Diễn đàn Kinh tế Thế giới dự báo tăng 50% mỗi năm cho đến năm 2030 – là “không thể bền vững”.

“Chúng ta cần tìm ra các giải pháp kỹ thuật, chính sách và những phương pháp khác để giải quyết vấn đề này một cách tập thể”, ông nhấn mạnh.

CUỘC ĐUA TRÁNH “THUẾ NVIDIA”

Để đạt được mục tiêu đó, đội ngũ của Andrew Wee tại Cloudflare đang thử nghiệm một loại vi mạch hoàn toàn mới từ Positron, một startup được thành lập vào năm 2023, vừa công bố huy động được 51,6 triệu USD trong vòng gọi vốn mới nhất.

Những con chip này hứa hẹn mang lại hiệu suất năng lượng vượt trội so với các sản phẩm của Nvidia – công ty dẫn đầu thị trường – trong nhiệm vụ quan trọng là “suy luận” (inference), quá trình mà AI tạo ra phản hồi từ các yêu cầu của người dùng. Dù các chip của Nvidia vẫn sẽ thống trị trong việc huấn luyện AI trong tương lai gần, việc cải thiện hiệu suất suy luận có thể giúp các công ty tiết kiệm hàng chục tỷ USD và lượng năng lượng tương ứng.

Theo Wall Street Journal, hiện nay, có ít nhất “một tá các startup” về chip đang cạnh tranh để cung cấp cho các nhà cung cấp dịch vụ đám mây những con chip suy luận tùy chỉnh cho tương lai. Đồng thời, các gã khổng lồ như Google, Amazon và Microsoft cũng đang đầu tư mạnh mẽ, nhiều năm liền, để phát triển chip tập trung vào suy luận, phục vụ các công cụ AI nội bộ và bán cho khách hàng thông qua dịch vụ đám mây của họ.

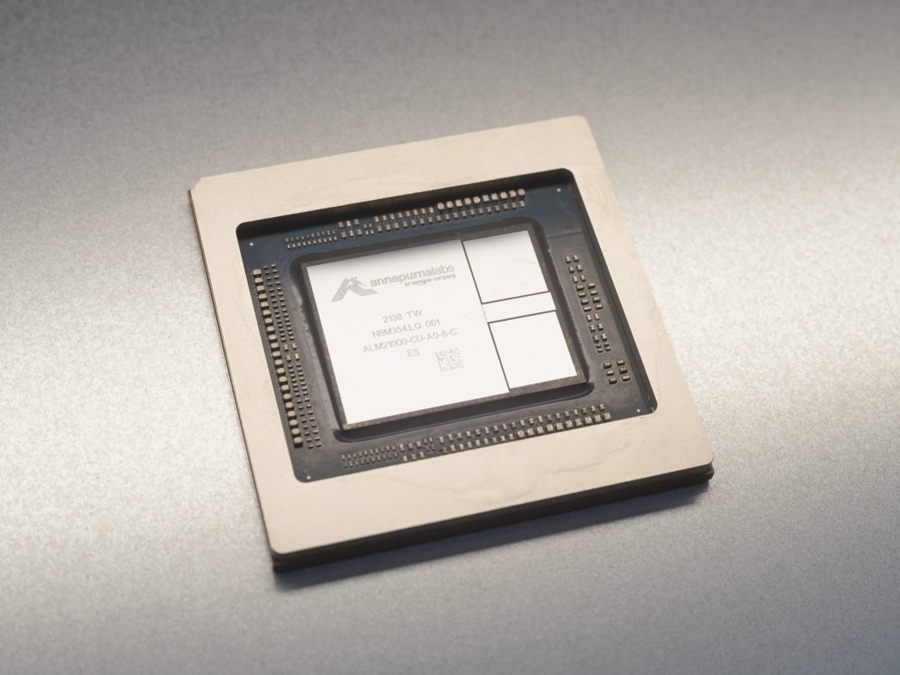

Phòng thí nghiệm sản xuất chip nội bộ của Amazon, Annapurna, đang xây dựng chip tập trung vào suy luận của riêng mình.

Mức độ quyết liệt của những nỗ lực này, cùng với quy mô đầu tư khổng lồ, cho thấy các gã khổng lồ công nghệ và startup đang khao khát mang AI đến tay người tiêu dùng và doanh nghiệp mà không phải trả cái giá được gọi là “thuế Nvidia” – tức mức lợi nhuận gộp khoảng 60% mà Nvidia thu được từ phần cứng của mình.

Nvidia nhận thức rõ tầm quan trọng ngày càng tăng của suy luận và những lo ngại về mức tiêu thụ năng lượng của AI. Dion Harris, giám đốc cấp cao tại Nvidia, người phụ trách bán phần cứng AI mới nhất cho các khách hàng lớn, cho biết hệ thống Blackwell mới nhất của Nvidia có hiệu suất suy luận cao gấp 25 đến 30 lần trên mỗi watt năng lượng so với thế hệ trước.

Để đạt được mục tiêu, các nhà sản xuất chip AI mới đang áp dụng một chiến lược đã từng thành công nhiều lần: thiết kế lại chip từ đầu, tập trung hoàn toàn vào các tác vụ mới đang trở nên quan trọng trong ngành công nghệ. Trong quá khứ, Nvidia đã xây dựng đế chế của mình nhờ các chip đồ họa, vốn sau này được phát hiện có thể tái sử dụng cho AI, nhưng không phải là giải pháp hoàn hảo.

Jonathan Ross, CEO của startup chip Groq, từng đứng đầu chương trình phát triển chip AI của Google. Ông thành lập Groq vì tin rằng có một cách tiếp cận hoàn toàn khác để thiết kế chip – tập trung duy nhất vào việc chạy các mô hình AI hiện nay.

Groq tuyên bố chip của họ có thể cung cấp AI nhanh hơn nhiều so với các chip tốt nhất của Nvidia, đồng thời sử dụng năng lượng chỉ bằng 1/3 đến 1/6. Điều này đến từ thiết kế độc đáo, tích hợp bộ nhớ trực tiếp trên chip thay vì tách biệt như thông thường. Mặc dù hiệu suất cụ thể phụ thuộc vào nhiều yếu tố, Jordan Nanos, nhà phân tích tại SemiAnalysis với 10 năm kinh nghiệm tại Hewlett Packard Enterprise, cho rằng tuyên bố của Groq về việc cung cấp suy luận với chi phí thấp hơn Nvidia là đáng tin cậy.

NHU CẦU VỀ CHIP AI SẼ KHÔNG NGỪNG TĂNG

Positron lại chọn một cách tiếp cận khác để tăng tốc suy luận. Công ty, đã cung cấp chip cho các khách hàng như Cloudflare, tạo ra một con chip đơn giản hóa với phạm vi khả năng hẹp hơn, nhằm thực hiện các tác vụ nhanh hơn. Vòng gọi vốn mới nhất của Positron, được dẫn dắt bởi Valor Equity Partners, Atreides Management và DFJ Growth, đã nâng tổng vốn đầu tư lên 75 triệu USD.

CEO của Positron, Mitesh Agrawal, cho biết hệ thống thế hệ tiếp theo của họ sẽ cạnh tranh với hệ thống Vera Rubin của Nvidia. Dựa trên lộ trình của Nvidia, chip của Positron hứa hẹn hiệu suất gấp 2-3 lần trên mỗi đô la và 3-6 lần trên mỗi đơn vị điện năng tiêu thụ.

Vi mạch của Positron hướng đến mục tiêu tiết kiệm năng lượng hơn nhiều so với Nvidia trong suy luận

Tuy nhiên, Dion Harris của Nvidia lập luận rằng các tuyên bố vượt trội về suy luận của đối thủ thường không tính đến tất cả các yếu tố mà khách hàng cân nhắc khi chọn phần cứng. Tính linh hoạt rất quan trọng, và nhu cầu của các công ty có thể thay đổi khi các mô hình AI mới và trường hợp sử dụng mới xuất hiện. “Khách hàng của Nvidia không nhất thiết bị thuyết phục bởi các ứng dụng suy luận chuyên biệt hơn,” ông nói.

Các thử nghiệm ban đầu của Cloudflare với chip của Positron đủ khả quan để thuyết phục Wee triển khai chúng vào các trung tâm dữ liệu của công ty cho các bài kiểm tra dài hạn, hiện vẫn đang tiếp diễn. Đây là điều mà chỉ một startup chip khác đạt được, Wee cho biết. “Nếu họ thực sự đáp ứng được các chỉ số đã quảng cáo, chúng tôi sẽ mở rộng quy mô và cho phép triển khai số lượng lớn trên toàn cầu,” ông nói thêm.

Bằng cách bình dân hóa phần cứng AI và cho phép khách hàng của Nvidia chuyển sang các hệ thống hiệu quả hơn, các lực lượng cạnh tranh có thể làm giảm đường cong nhu cầu năng lượng của AI trong tương lai, theo Wee. “Hiện tại có rất nhiều FOMO (sợ bỏ lỡ cơ hội), nhưng cuối cùng, tôi nghĩ lý trí sẽ bắt kịp với thực tế”, ông nhận định.

Một chân lý trong lịch sử ngành máy tính là mỗi khi các kỹ sư phần cứng tìm ra cách làm việc nhanh hơn hoặc hiệu quả hơn, các lập trình viên – và người tiêu dùng – sẽ nhanh chóng tìm cách tận dụng toàn bộ hiệu suất mới, thậm chí còn đòi hỏi nhiều hơn.

Mark Lohmeyer, phó chủ tịch mảng AI và cơ sở hạ tầng máy tính tại Google Cloud, nơi cung cấp cả chip AI tùy chỉnh của Google và chip của Nvidia cho Google và khách hàng đám mây, cho biết sự chấp nhận của người tiêu dùng và doanh nghiệp đối với các mô hình AI mới, đòi hỏi cao hơn, đồng nghĩa với việc không có điểm dừng cho nhu cầu về AI, bất kể đội ngũ của ông có thể cung cấp AI hiệu quả đến đâu. Giống như hầu hết các nhà cung cấp AI lớn khác, Google đang tìm kiếm những cách thức mới để sản xuất năng lượng, bao gồm cả năng lượng hạt nhân và năng lượng tổng hợp (fusion), để đáp ứng nhu cầu này.

Dù các con chip mới có thể giúp các công ty riêng lẻ cung cấp AI hiệu quả hơn, toàn ngành công nghiệp vẫn đang trên đà tiêu thụ ngày càng nhiều năng lượng. Một báo cáo gần đây từ Anthropic chỉ ra rằng năng lượng, chứ không phải trung tâm dữ liệu hay chip, có thể là nút thắt thực sự cho sự phát triển của AI trong tương lai.

Bài toán năng lượng của AI không chỉ là một thách thức kỹ thuật mà còn là một vấn đề đòi hỏi sự hợp tác toàn diện giữa công nghệ, chính sách và sáng tạo. Cuộc đua để tạo ra những con chip hiệu quả hơn chỉ là một phần của câu chuyện, trong khi thế giới vẫn đang tìm kiếm câu trả lời cho nhu cầu năng lượng không ngừng tăng của trí tuệ nhân tạo.

Thanh Minh

Nguồn VnEconomy : https://vneconomy.vn/big-tech-va-startup-dang-chay-dua-thiet-ke-loai-chip-moi-giai-quyet-van-de-ngon-nang-luong-cua-ai.htm

Tin khác

Google đối đầu Australia vì lệnh cấm mạng xã hội trẻ em

một ngày trước

Trung Quốc tung ra mẫu AI mới, tuyên bố 'rẻ hơn cả DeepSeek' khiến thị trường dậy sóng

11 giờ trước

Trung Quốc thành lập liên minh AI nội địa: Bước đi chiến lược trước áp lực quốc tế

14 giờ trước

iPhone và Samsung Galaxy sẽ ra sao nếu không có Chrome?

20 giờ trước

Lượng chip Nvidia tỷ USD được buôn lậu sang Trung Quốc như thế nào

2 ngày trước

Nếu nhận được email này, tài khoản Google của bạn đang bị tấn công

2 ngày trước