Chuyên gia chỉ 'mẹo' nhận biết cuộc gọi Deepfake lừa đảo

Cục An toàn thông tin mới đây đã phát đi cảnh báo liên quan đến tình trạng lừa đảo giả mạo video, hình ảnh bằng công nghệ cao tiếp tục tái diễn.

Theo đó, tình trạng tội phạm mạng lợi dụng hình ảnh, video công khai của người dân để chỉnh sửa, cắt ghép, đe dọa tống tiền bằng các video giả mạo đã được cơ quan chức năng cảnh báo rộng rãi tới đông đảo người dân.

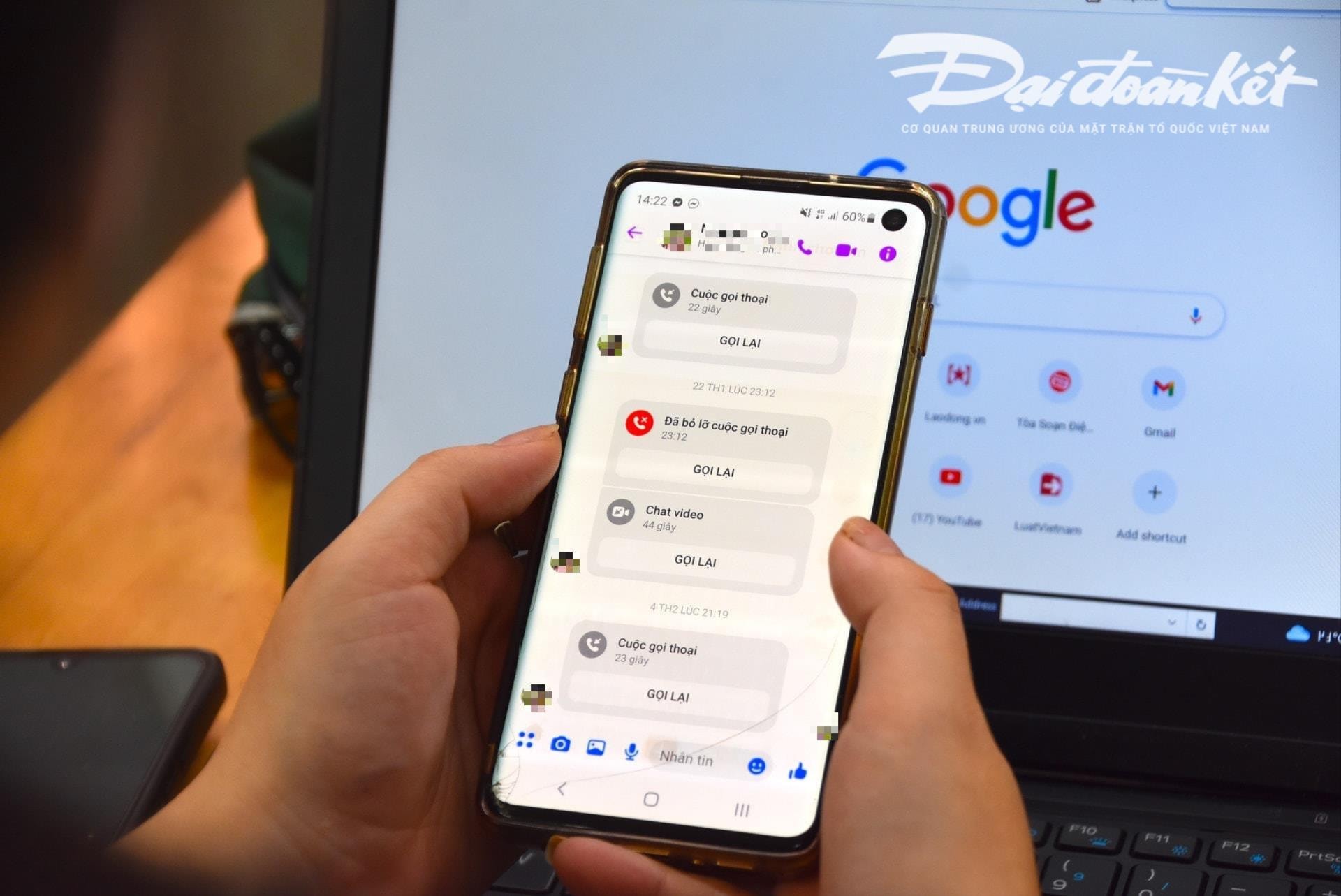

Ảnh minh họa: Hoàng Chiến.

Sử dụng công nghệ Deepfake cho phép tái tạo âm thanh và hình ảnh của một người với độ chính xác cao, kẻ gian có thể giả mạo các nhà lãnh đạo trong các cuộc họp trực tuyến, hoặc dựng các video, cuộc gọi nhằm lừa đảo tài chính.

Hơn thế, các chiêu trò lừa đảo này thường khai thác yếu tố tâm lý như sự khẩn cấp, sợ hãi hoặc quyền lực, khiến nạn nhân hành động vội vàng mà không kiểm tra kỹ tính xác thực.

Deepfake không chỉ dừng lại ở các vụ lừa đảo đầu tư tài chính. Một ví dụ khác là các vụ lừa đảo tình cảm, trong đó Deepfake được sử dụng để tạo ra các nhân vật hư cấu, tương tác với nạn nhân qua các cuộc gọi video; sau khi lấy được lòng tin của nạn nhân, kẻ lừa đảo sẽ yêu cầu chuyển tiền để giải quyết các tình huống khẩn cấp, chi phí đi lại, hoặc các khoản vay.

Trước tình hình trên, Cục An toàn thông tin khuyến cáo người dân cảnh giác với những lời khuyên đầu tư từ người nổi tiếng trên mạng xã hội; cảnh giác với những tin nhắn, email hoặc cuộc gọi không xác định; cần quan sát kỹ những biểu cảm khuôn mặt không tự nhiên trong các video.

Người dân cũng cần hạn chế đăng tải nội dung liên quan đến thông tin cá nhân lên mạng xã hội để tránh trường hợp bị các đối tượng xấu đánh cắp thông tin như hình ảnh, video hoặc giọng nói; đồng thời, cài đặt tài khoản ở chế độ riêng tư để bảo vệ thông tin cá nhân.

Trao đổi với PV Báo Đại Đoàn Kết, chuyên gia an ninh mạng Ngô Minh Hiếu, đồng sáng lập Dự án Chống lừa đảo trên không gian mạng Việt Nam (Chongluadao.vn) cho biết, việc sử dụng công nghệ Deepfake (giả lập sâu) trong AI để làm giả các cuộc gọi video nhằm mục đích lừa đảo vẫn đang diễn biến phức tạp. Các đối tượng khai thác công nghệ này để làm tăng độ tin cậy của “con mồi”.

Cụ thể, các đối tượng sẽ chủ động thực hiện các cuộc gọi video call đến nạn nhân từ những hình ảnh, video đã được “ăn cắp” trước đó và xử lý kĩ thuật, làm méo mó âm thanh hoặc giả sự cố hình ảnh để lấy lòng tin nạn nhân.

Thông thường, các cuộc gọi này rất ngắn, chỉ kéo dài vài giây rồi lấy lí do mạng chập chờn, đi ngoài đường… để yêu cầu nạn nhân thực hiện các yêu cầu của đối tượng lừa đảo.

Chuyên gia cảnh báo, việc sử dụng AI để lừa đảo trên không gian mạng sẽ có thể gia tăng đáng kể trong thời gian tới. Do vậy, người dân phải chủ động nâng cao ý thức cảnh giác của mình. Đặc biệt là khi nhận các tin nhắn, cuộc gọi video, đường links lạ.

Theo phân tích của chuyên gia này, thuật toán của trí tuệ nhân tạo (AI) Deepfake hiện nay trong lúc thực hiện cuộc gọi thời gian thực sẽ không xử lý được nếu người gọi quay trái, quay phải hoặc đứng lên...

Một điểm yếu đặc biệt người dân cần lưu ý khi nhận các cuộc gọi này là hàm răng. Theo đó, các thuật toán AI hiện nay chưa tái hiện được hàm răng như của người bị giả mạo.

Nếu sử dụng Deepfake, hình ảnh lúc há miệng của đối phương có thể không có hàm răng, có người lại có 3 hàm, thậm chí 4 hàm. Vì vậy, đặc điểm của hàm răng là yếu tố dễ nhận biết nhất của cuộc gọi giả mạo dùng Deepfake.

“Chậm lại” và không thực hiện theo yêu cầu ngay lập tức là điều kiện tiên quyết để tránh sập bẫy lừa đảo. Khi nhận bất kỳ tin nhắn, cuộc gọi nào thông qua mạng xã hội, người dân cần điện thoại trực tiếp cho người thân để xác minh chính xác người đang liên hệ với mình là ai với thời gian tối thiểu trên 30 giây hoặc gặp mặt trực tiếp.

Trường hợp nghi vấn đối tượng giả mạo người thân trên mạng xã hội để lừa đảo, chiếm đoạt tài sản, cần báo ngay cho cơ quan công an gần nhất để được hỗ trợ, xử lý kịp thời.

Hoàng Chiến

Nguồn Đại Đoàn Kết : https://daidoanket.vn/chuyen-gia-chi-meo-nhan-biet-cuoc-goi-deepfake-lua-dao-10300910.html

Tin khác

Ngắm cực phẩm công nghệ Make in Vietnam tại Hội nghị Di động thế giới

6 giờ trước

Nhận cuộc gọi đến nhưng đầu dây bên kia không nói gì: Đây là chiêu lừa đảo gì?

10 giờ trước

Meta, TikTok, Snapchat phản đối việc YouTube được Úc miễn trừ khỏi lệnh cấm mạng xã hội với trẻ em

2 giờ trước

Tối đa hóa giá trị mạng 5G trong kỷ nguyên AI

2 giờ trước

MWC 2025: Các hãng smartphone Trung Quốc nhờ AI của Google để cạnh tranh với Apple và Samsung ở nước ngoài

2 giờ trước

Tăng hơn mười bậc, tốc độ Internet di động Việt Nam xếp hạng 22 thế giới

3 giờ trước