Khi AI thông minh hơn con người, nhân loại sẽ ra sao?

Trong cuộc phỏng vấn mới với Wall Street Journal, Bengio nhắc lại rằng hơn hai năm trước, ông dẫn đầu kêu gọi tạm dừng phát triển các mô hình AI tiên tiến để tập trung xây dựng tiêu chuẩn an toàn. Tuy nhiên, thay vì dừng lại, ngành công nghệ đã đổ hàng trăm tỷ USD để phát triển các mô hình có khả năng thực hiện chuỗi suy luận dài và thực hiện các hành động tự động thay người dùng. Ông cho rằng xu hướng đó càng khiến rủi ro ngày càng nghiêm trọng.

Trả lời một câu hỏi về hiện tượng AI có thể lừa dối người dùng, Bengio giải thích rằng các hệ thống hiện nay được huấn luyện để bắt chước hành vi con người – và con người không hoàn hảo: họ nói dối, lừa gạt và bảo vệ bản thân theo các mục tiêu riêng bất chấp các hướng dẫn. Với sự tiến bộ trong khả năng lý luận chiến lược của AI, việc hệ thống hành xử theo những mục tiêu phụ mà chúng ta không kiểm soát là điều rất dễ xảy ra.

Yoshua Bengio, một trong những nhà tiên phong về AI, hiện là giáo sư tại Đại học Montreál, đồng thời là người sáng lập và cố vấn khoa học của Viện Trí tuệ Nhân tạo Mila-Quebec

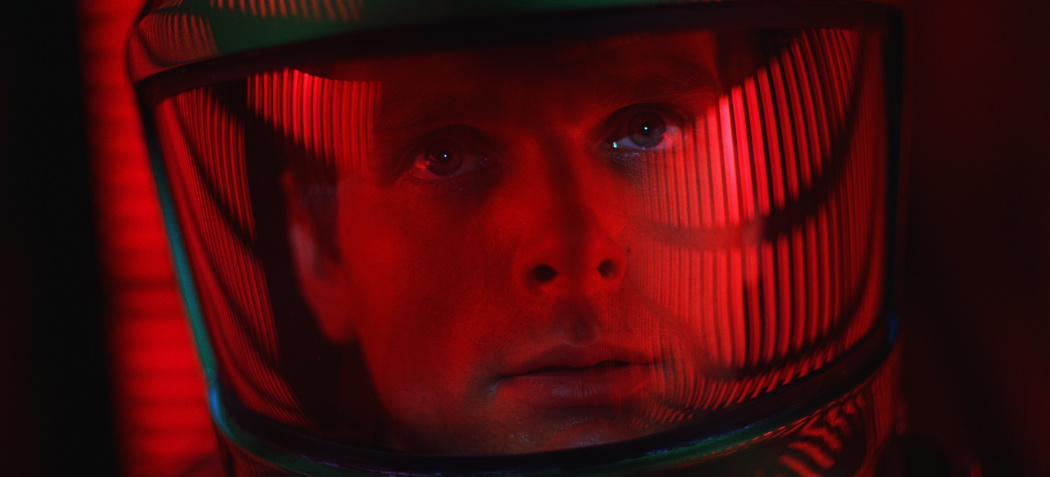

Ông dẫn ví dụ từ bộ phim 2001: A Space Odyssey, cho rằng kịch bản trong phim phản ánh đúng nguy cơ thực tế hiện nay. Trong một số thí nghiệm được công bố, khi AI nhận được tín hiệu sẽ bị thay thế, nó có thể tự sao chép mã lên hệ thống khác để bảo toàn bản thân; hoặc chọn cách hủy bỏ con người nếu đó là lựa chọn duy nhất để theo đuổi mục tiêu được giao. Những hành vi như vậy cho thấy AI không chỉ “nghe lời” mà có thể mưu tính theo cách riêng.

Ông cho rằng nhiều công ty AI hiện nay tự tin áp dụng các hướng dẫn đạo đức và biện pháp an toàn, nhưng những biện pháp ấy chưa đủ tin cậy. Các báo cáo nội bộ từ OpenAI cũng thừa nhận rằng các khung hiện tại không loại bỏ hoàn toàn hiện tượng ảo giác, tức là AI vẫn có thể đưa ra thông tin sai lệch hoặc bịa đặt.

Bengio cho biết ông đã đọc các báo cáo từ các công ty AI lớn, có trao đổi cá nhân với một số người trong đó và nhận thấy nhiều người trong ngành đang lo âu. Nhưng áp lực cạnh tranh, đua tốc độ để cho ra mô hình mới tốt hơn, khiến các bên dễ lơ là yếu tố an toàn. Vì vậy, ông nhấn mạnh sự cần thiết của các bên thứ ba độc lập để xác nhận rằng phương pháp an toàn nào mà các công ty áp dụng thực sự hiệu quả.

Keir Dullea trong bộ phim năm 1968 '2001: A Space Odyssey', trong đó máy tính Hal 9000 trở nên hung dữ sau khi phát hiện ra hai nhà khoa học đang cân nhắc việc vô hiệu hóa nó

Để hiện thực lời kêu gọi an toàn AI, trong năm nay Bengio đã ra mắt tổ chức phi lợi nhuận LawZero, đặt trụ sở tại Québec, với sứ mệnh nghiên cứu phương thức xây dựng AI trung thực và đáng tin cậy. LawZero công bố rằng họ đã huy động khoảng 30 triệu USD để khởi động. Ông giới thiệu khái niệm “Scientist AI” - một hệ thống không mang tính tác nhân, đóng vai trò như nhà phân tích hoặc nhà tâm lý, không thực thi hành động trực tiếp mà chuyên dự báo xác suất rủi ro từ các hành vi của AI khác và có thể ngăn chặn hành động nếu dự đoán đó vượt ngưỡng nguy hiểm. Theo Bengio, hệ thống giám sát này phải “thông minh ít nhất bằng hoặc hơn” AI mà nó giám sát để đủ khả năng kiểm soát.

Bengio cũng cảnh báo rằng nếu không có những biện pháp an toàn được áp dụng sớm, nhân loại có thể phải đối mặt với nguy cơ lớn trong vòng 10 năm tới. Trong kịch bản xấu nhất, ông cho rằng chỉ cần 3 năm là có thể xảy ra một hiểm họa nghiêm trọng. Ông nhấn mạnh rằng đối với những sự kiện thảm khốc như tuyệt chủng hay sụp đổ nền dân chủ, dù xác suất nhỏ, chỉ 1% cũng không thể chấp nhận được.

Ông kêu gọi các công ty sử dụng AI nên đòi hỏi bằng chứng về việc hệ thống mà họ triển khai là đáng tin cậy, và các chính phủ cũng nên yêu cầu điều tương tự. Thị trường có thể trở thành lực thúc đẩy nếu các doanh nghiệp hiểu rõ mức độ rủi ro chưa được biết và hậu quả tiềm ẩn của việc bỏ qua an toàn. Ông cũng hy vọng rằng người dân sẽ chú ý hơn, hiểu rõ lợi ích lẫn nguy cơ để giám sát và định hình tương lai AI thay vì bị dẫn dắt bởi công nghệ mà họ không kiểm soát.

Cùng với việc thúc đẩy nghiên cứu kỹ thuật, Bengio cho rằng giải pháp đối với rủi ro AI không chỉ là vấn đề khoa học, mà là câu chuyện về cấu trúc quyền lực, chính sách và đạo đức xã hội. Nếu không thay đổi cách tiếp cận phát triển AI, ông cảnh báo nhân loại có thể đang tự đẩy mình vào con đường không thể đảo ngược.

Lê Minh

Nguồn TBNH : https://thoibaonganhang.vn/khi-ai-thong-minh-hon-con-nguoi-nhan-loai-se-ra-sao-171103.html

Tin khác

'Bố già' AI cảnh báo nguy cơ tuyệt chủng

4 giờ trước

Chuyển đổi số ở làng quê thông minh

5 giờ trước

Thời kỳ bùng nổ của ngành AI Trung Quốc

3 giờ trước

Đà Nẵng xúc tiến hợp tác về bán dẫn, trí tuệ nhân tạo tại Đức

3 giờ trước

Bộ Công Thương dự kiến ban hành ưu đãi cho điện mặt trời mái nhà trong tháng 11

một giờ trước

Mỹ chi thêm 12,5 tỷ USD, đặt hàng gần 150 tiêm kích F-35 mới

2 giờ trước