Những từ ngữ chỉ trích công nghệ mới xuất hiện

Trong số đó không thiếu từ ngữ mang ý nghĩa tiêu cực, chỉ trích chất lượng dịch vụ, tác động hay bản thân công nghệ cụ thể. Tuy nhiên không phải ai cũng hiểu chúng.

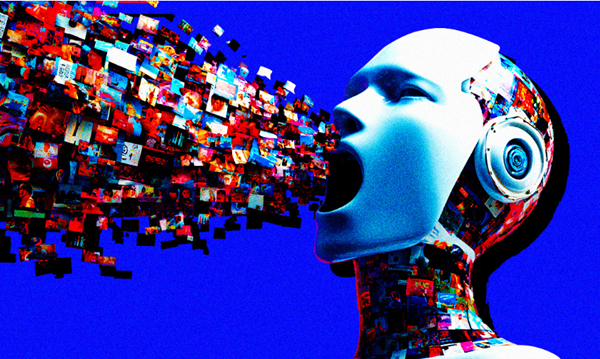

AI slop

Rất nhiều nội dung trên internet có thể bị liệt vào diện “AI slop” (tạm dịch: rác AI). Từ này chỉ nội dung - hình ảnh hoặc văn bản - chất lượng thấp do trí tuệ nhân tạo (AI) tạo ra. Chúng giống như “rác” do rất cẩu thả, phi logic, chẳng đem lại lợi ích thiết thực gì mà lại lan tràn khắp mạng xã hội.

Lập trình viên máy tính người Anh Simon Willison được ghi nhận là một trong số người dùng thuật ngữ “AI slop” đầu tiên. Tuy nhiên, bản thân ông cho biết từ này đã được sử dụng từ lâu trước đó.

“AI slop” phổ biến từ giữa năm 2024, khi Google bắt đầu triển khai nền tảng Gemini trả lời các truy vấn tìm kiếm.

Nhiều nội dung AI giống "rác" - Ảnh: Cybernews

Brainrot

Cuộc bình chọn với hơn 37.000 người tham gia do nhà xuất bản Đại học Oxford thực hiện cho kết quả “brainrot” (tạm dịch: thối não) là từ của năm 2024. Từ này chỉ tình trạng suy giảm về tinh thần hay trí tuệ, đặc biệt được xem như kết quả của việc tiếp nhận quá nhiều nội dung (đặc biệt hiện nay là nội dung trực tuyến) tầm thường hoặc không có giá trị.

“Brainrot” không trực tiếp chỉ trích mạng xã hội hay công nghệ mà bày tỏ mối quan ngại về tác động của việc tiếp nhận quá nhiều nội dung trực tuyến chất lượng thấp, triệu tiêu khả năng sáng tạo lẫn tư duy phản biện. Nó lần đầu xuất hiện vào năm 1854 trong quyển sách Walden của Henry David Thoreau, kể lại trải nghiệm bản thân khi sống một cách giản dị giữa thiên nhiên. Ông dùng từ này chỉ trích xu hướng hạ thấp giá trị những ý tưởng phức tạp của xã hội.

Đến thời đại số, “brainrot” mang ý nghĩa mới và hiện được giới trẻ lẫn báo chí chính thống sử dụng rộng rãi. Thảo luận về tác động tiêu cực tiềm tàng mà việc tiếp nhận quá nhiều nội dung trực tuyến chất lượng thấp cũng thu hút ngày càng nhiều sự chú ý. Thậm chí vào đầu năm nay một trung tâm sức khỏe tâm thần ở Mỹ còn công bố hướng dẫn cách nhận biết và tránh “brainrot”.

Snake oil

“Snake oil” (mỡ rắn) bắt nguồn từ mỡ thoa lấy từ rắn bán vào thế kỷ 18 - 19. Lúc đó nhiều thương nhân phương Tây bán thuốc mỡ phối trộn từ thảo dược, gia vị, hợp chất gia dụng nhưng không chứa bất cứ thành phần nào có nguồn gốc từ rắn, mặc dù vậy họ vẫn quảng cáo đây là mỡ rắn trị bách bệnh. Vì vậy “snake oil” trở thành từ chỉ sản phẩm - thường là dược phẩm - được tung hô rất thần kì nhưng hóa ra lại vô dụng, lợi ích chẳng có căn cứ khoa học.

Đến thời đại AI, “snake oil” phổ biến trở lại. Chẳng ai tin vào tuyên bố của giám đốc điều hành OpenAI Sam Altman, rằng trí tuệ nhân tạo tổng quát (AGI) đủ sức giải quyết mọi vấn đề vật lý và nâng tầm nhân loại. Giáo sư Arvind Narayanan (Đại học Princeton) từng viết sách nêu rõ một số công cụ trí tuệ nhân tạo không hiệu quả trong cuộc sống thực.

Không ít công cụ AI chẳng hiệu quả trong thực tế - Ảnh: Cybernews

Enshittification

Năm 2022, nhà báo kiêm blogger người Anh Cory Doctorow làm nên lịch sử khi nghĩ ra “enshittification” (tạm dịch: suy thoái) mô tả chính xác mô hình kinh doanh của loạt dịch vụ số ngày nay đồng thời bày tỏ sự thất vọng đối với chúng.

Ông xác định một nền tảng lúc mới triển khai sẽ cung cấp dịch vụ chất lượng cao miễn phí hoặc mức phí thấp nhằm thu hút người dùng đại chúng. Khi đạt lượng người dùng ổn định thì nền tảng “hi sinh” người dùng đại chúng, chuyển sang tập trung nhóm khách hàng doanh nghiệp để đạt lợi nhuận (chẳng hạn chấp nhận chạy quảng cáo thu hút doanh nghiệp) khiến trải nghiệm bị ảnh hưởng. Cuối cùng khi vị trí trên thị trường đã vững chắc nền tảng tập trung tối ưu hóa lợi nhuận cho chính mình cùng cổ đông dẫn đến “hi sinh” lợi ích người dùng đại chúng lẫn người dùng doanh nghiệp.

Staocastic parrot

“Staocastic parrot” (tạm dịch: con vẹt ngẫu tính) chỉ các mô hình ngôn ngữ lớn (LLM) không có nhận thức ngữ cảnh hoặc kiến thức ngữ nghĩa mà đưa ra thông tin một cách ngẫu nhiên dựa trên khuôn mẫu và xác suất thống kê. Chính điều này khiến LLM tiềm ẩn nguy hiểm, vì chúng duy trì nhiều định kiến khác nhau và trình bày như sự thật khiến mọi người tin theo.

LLM không có nhận thức ngữ cảnh hoặc kiến thức ngữ nghĩa - Ảnh: Cybernews

Clanker

Phổ biến rộng rãi nhờ loạt phim ăn khách Star Wars, “clanker” (nghĩa đen: thứ kêu lạch cạch) mang đậm sắc thái châm biếm dành cho AI và robot.

Sau thành công vang dội của ChatGPT cũng như robot tự hành, tâm lý phản đối công nghệ ngày càng tăng cao. Trên mạng xã hội xuất hiện vô số nội dung dùng từ “clanker”. Tờ The New York Times từng chia sẻ đoạn phim một người đàn ông chửi rủa robot mà mình nhìn thấy trên phố: “Hãy mang clanker bẩn thỉu này ra khỏi đây!”. Từ này gợi lên hình ảnh một thiết bị công nghệ vô dụng, cồng kềnh, không thực sự hiệu quả.

Chim hoàng yến trong mỏ than

Chim hoàng yến từng được thợ mỏ mang theo bên mình, thực hiện nhiệm vụ thăm dò. Chúng yếu đi hoặc chết nghĩa là trong mỏ đang có khí độc không thể tiến vào. Kinh nghiệm này sau đó phép ẩn dụ vô cùng phổ biến.

Ở thời đại AI, mọi người dùng “chim hoàng yến trong mỏ than” để nói về tác động của AI lên thị trường việc làm. Giới trẻ như “chim hoàng yến” khi các doanh nghiệp chạy đua ứng dụng trí tuệ nhân tạo.

Cẩm Bình

Nguồn Một Thế Giới : https://1thegioi.vn/nhung-tu-ngu-chi-trich-cong-nghe-moi-xuat-hien-237226.html

Tin khác

Apple đạt kỷ lục 9 tỷ USD doanh thu tại Ấn Độ trước thềm ra mắt iPhone 17

một giờ trước

Vũ khí mới trong cuộc đua công nghệ trên chiến trường hiện đại

một giờ trước

Tổng thống Putin mở tài khoản trên nền tảng nhắn tin MAX Messenger

8 giờ trước

Học ngoại ngữ 'chưa bao giờ dễ đến thế' với 5 công cụ AI này

11 giờ trước

Chuyển đổi sang tài khoản giao thông, nhiều tiện ích mới

10 giờ trước

Bất cứ ai dùng ChatGPT cũng phải biết: Chuyên gia bảo mật hướng dẫn cách ngăn chặn các cuộc trò chuyện của bạn xuất hiện trên Google

10 giờ trước