Vì sao HBM là cứu tinh dọn đường cho kỷ nguyên AI?

HBM giúp tốc độ xử lý thông tin tăng mạnh đáp ứng nhu cầu trong kỷ nguyên AI

Chúng ta đang sống trong những ngày tháng mà cả thế giới lên cơn sốt vì trí tuệ nhân tạo. Từ những quán cà phê vỉa hè cho đến các phòng họp kín của những tập đoàn nghìn tỉ đô, đâu đâu người ta cũng bàn tán về ChatGPT, về Gemini, hay về sức mạnh tính toán khủng khiếp của những con chip NVIDIA H100 có giá bằng cả một gia tài. Nhưng đằng sau ánh hào quang rực rỡ của những mô hình ngôn ngữ lớn hay những bộ vi xử lý tối tân ấy, có một nghịch lý trớ trêu đang âm thầm diễn ra mà ít ai để ý.

Hãy tưởng tượng bạn đang sở hữu một chiếc siêu xe Ferrari động cơ V12 dũng mãnh, có khả năng xé gió với vận tốc 400km/h. Đó chính là những con chip GPU hiện đại nhất. Nhưng bi kịch thay, chiếc siêu xe ấy lại bị ép buộc phải di chuyển trên một con đường đất gồ ghề, chật hẹp và kẹt cứng xe cộ vào giờ cao điểm. Con đường đau khổ ấy chính là công nghệ bộ nhớ truyền thống.

Sức mạnh của những "bộ não" AI vĩ đại đang bị lãng phí một cách khủng khiếp chỉ vì chúng không thể nạp dữ liệu đủ nhanh để xử lý. Chính từ nghịch lý "Ferrari tắc đường" này, công nghệ HBM (High Bandwidth Memory - Bộ nhớ băng thông cao) đã bước ra ánh sáng như một vị cứu tinh. HBM không chỉ đơn thuần là một linh kiện nâng cấp; nó là hành động trải nhựa lại toàn bộ hạ tầng giao thông, biến con đường đất chật hẹp thành một đại lộ cao tốc mười làn xe thênh thang. Nhưng thực chất HBM là gì, và tại sao trước khi cơn bão AI ập đến, nó từng là một công nghệ bị ghẻ lạnh và lãng quên?

Lời nguyền "Bức tường bộ nhớ" và sự bất lực của những gã khổng lồ cũ

Để hiểu tại sao thế giới lại khao khát HBM đến điên cuồng, chúng ta cần quay ngược lại một chút về nguyên lý hoạt động cơ bản của máy tính. Trong suốt nhiều thập kỷ, tốc độ xử lý của chip (CPU và GPU) đã tăng trưởng theo cấp số nhân, tuân theo định luật Moore trứ danh. Những con chip ngày nay có thể thực hiện hàng nghìn tỷ phép tính mỗi giây, nhanh như những tia chớp điện tử.

Thế nhưng, tốc độ truy xuất dữ liệu từ bộ nhớ DRAM lại không thể chạy đua kịp với tốc độ ấy. Khoảng cách mênh mông giữa tốc độ xử lý siêu nhanh của chip và tốc độ cung cấp dữ liệu lẹt đẹt của bộ nhớ đã tạo ra một thuật ngữ ám ảnh giới kỹ sư bán dẫn: "Bức tường bộ nhớ" (The Memory Wall).

Hãy hình dung con chip GPU của bạn giống như một đầu bếp siêu hạng đẳng cấp Michelin, người có thể thái rau và nấu chín món ăn chỉ trong tích tắc. Còn bộ nhớ GDDR (loại bộ nhớ thường thấy trong các card đồ họa chơi game hay máy tính thông thường) giống như một kho nguyên liệu nằm ở tòa nhà bên kia đường. Mỗi khi đầu bếp cần một củ hành hay miếng thịt, người phụ bếp phải chạy băng qua đường, vào kho lấy đồ rồi chạy ngược về.

Dù người phụ bếp có chạy nhanh đến đâu, quãng đường vật lý đó vẫn tồn tại. Hệ quả là vị đầu bếp tài ba kia phần lớn thời gian phải đứng chơi xơi nước, gõ tay lên bàn bếp chờ đợi nguyên liệu được mang về. Trong thế giới của AI, nơi các mô hình huấn luyện có tới hàng nghìn tỷ tham số cần được nạp và xả liên tục, sự chờ đợi này là một sự lãng phí tài nguyên không thể chấp nhận được.

Công nghệ bộ nhớ GDDR truyền thống được thiết kế giống như việc quy hoạch những căn nhà cấp 4 trải rộng trên mặt đất. Muốn tăng dung lượng bộ nhớ, các kỹ sư buộc phải nới rộng diện tích bảng mạch để đặt thêm các chip nhớ nằm cạnh nhau. Việc này không chỉ tốn diện tích mà còn khiến tín hiệu điện phải di chuyển một quãng đường xa hơn để đến được vi xử lý trung tâm.

Điều này đồng nghĩa với độ trễ cao hơn và năng lượng tiêu tốn nhiều hơn chỉ để... truyền tin. Đối với các tác vụ chơi game hay văn phòng, sự chậm trễ này có thể chấp nhận được, nhưng với cơn khát dữ liệu của AI, kiến trúc "nhà cấp 4" này đã hoàn toàn lỗi thời và trở thành nút thắt cổ chai bóp nghẹt hiệu năng của toàn hệ thống.

HBM: Cuộc cách mạng "Xây nhà cao tầng" trên vi mạch

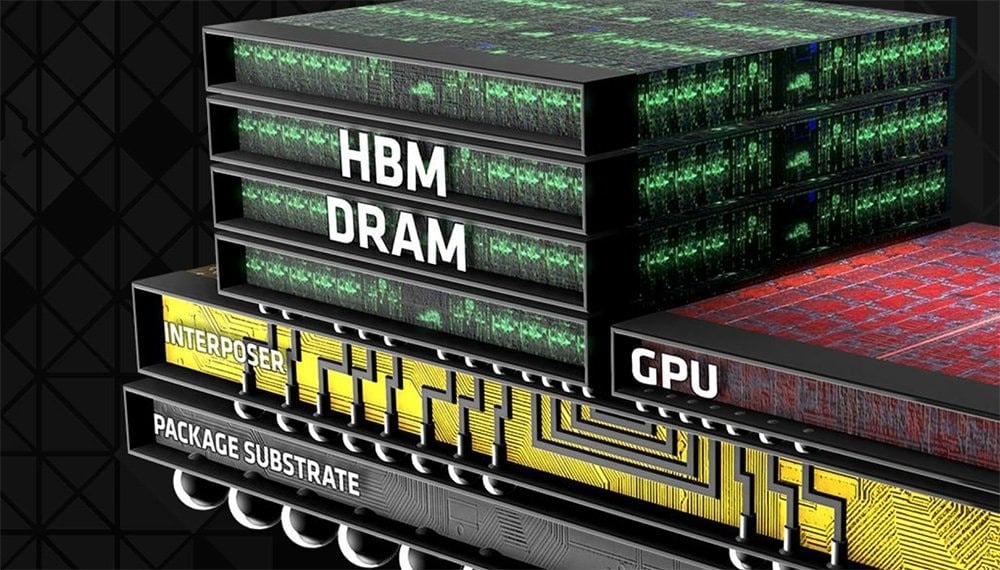

Đứng trước bế tắc đó, các kỹ sư bán dẫn đã nảy ra một ý tưởng táo bạo: Nếu không thể mở rộng theo chiều ngang vì tốn diện tích và đường xa, tại sao chúng ta không phát triển theo chiều dọc? Và thế là HBM ra đời, mang theo triết lý của việc quy hoạch đô thị hiện đại vào trong thế giới vi mạch. Thay vì rải rác các chip nhớ trên mặt phẳng như những ngôi nhà cấp 4, công nghệ HBM xếp chồng các lớp chip nhớ DRAM lên nhau thẳng đứng, tạo thành những tòa cao ốc chọc trời ngay trên đế silicon.

Mô phỏng công nghệ xếp chồng trong HBM

Sự kỳ diệu của HBM nằm ở một công nghệ lõi có tên gọi nghe khá kỹ thuật là TSV (Through-Silicon Via), nhưng bản chất của nó rất dễ hiểu. Hãy tưởng tượng thay vì đi cầu thang bộ bên ngoài tòa nhà, người ta đục hàng nghìn giếng thang máy xuyên thẳng qua các tầng lầu từ đỉnh xuống đáy. Những "thang máy" TSV này là các đường dẫn tín hiệu điện cực nhỏ xuyên qua từng lớp silicon, cho phép dữ liệu di chuyển theo chiều dọc với tốc độ chóng mặt. Nhờ kiến trúc xếp chồng này, HBM có thể đạt được mật độ dung lượng khổng lồ trong một diện tích nhỏ bé đến khó tin.

Chưa dừng lại ở đó, HBM còn thay đổi hoàn toàn vị trí địa lý của bộ nhớ. Thay vì nằm ở "tòa nhà bên kia đường" như GDDR, các khối HBM được đặt nằm sát sạt ngay cạnh con chip GPU, trên cùng một tấm đế trung gian (Interposer). Giờ đây, vị đầu bếp Michelin của chúng ta không cần chờ đợi nữa, vì kho nguyên liệu đã được dời về ngay trong căn bếp, chỉ cần với tay là tới. Khoảng cách vật lý được rút ngắn tối đa giúp giảm độ trễ và tiết kiệm năng lượng đáng kể.

Nhưng vũ khí lợi hại nhất của HBM chính là băng thông – độ rộng của con đường vận chuyển dữ liệu. Nếu ví bộ nhớ GDDR cao cấp nhất hiện nay như một con đường quốc lộ có 32 làn xe, thì HBM giống như một siêu xa lộ với 1024 làn xe chạy song song. Dù mỗi chiếc xe trên làn đường HBM có thể chạy chậm hơn một chút so với GDDR (tần số xung nhịp thấp hơn), nhưng với số lượng làn đường gấp hàng chục lần, tổng lượng hàng hóa (dữ liệu) được vận chuyển trong cùng một thời điểm của HBM là vượt trội hoàn toàn. Chính khả năng vận chuyển khối lượng dữ liệu khổng lồ cùng lúc này đã biến HBM trở thành "người được chọn" cho kỷ nguyên AI.

Từ "con ghẻ" của AMD đến "ngôi sao" của kỷ nguyên AI

Tuy nhiên, ít ai biết rằng trước khi trở thành "vàng đen" của ngành bán dẫn, HBM từng có một quá khứ lận đận. Quay ngược thời gian về năm 2015, AMD – đối thủ truyền kiếp của NVIDIA – là kẻ tiên phong mang công nghệ HBM thế hệ đầu tiên lên dòng card đồ họa Radeon R9 Fury X. Khi ấy, đó là một kiệt tác công nghệ thực sự, nhỏ gọn và mạnh mẽ. Nhưng Fury X đã thất bại. Nó thất bại không phải vì công nghệ tồi, mà vì nó sinh ra không đúng thời.

Vào thời điểm đó, thị trường chính của card đồ họa là các game thủ. Các trò chơi điện tử cần dung lượng bộ nhớ lớn để chứa vân bề mặt (texture) và cần độ trễ cực thấp, nhưng chúng lại không quá "khát" băng thông khủng khiếp mà HBM mang lại.

Hơn nữa, quy trình sản xuất HBM quá phức tạp và đắt đỏ khiến giá thành sản phẩm đội lên cao ngất ngưởng, khiến người dùng quay lưng. HBM lúc bấy giờ giống như một món trang sức xa xỉ nhưng thừa thãi, một công nghệ "con ghẻ" đi trước thời đại mà không ai thực sự cần đến. SK Hynix và Samsung, những nhà sản xuất bộ nhớ, đã từng có lúc muốn buông xuôi mảng này vì không thấy lợi nhuận.

Thế nhưng, thời thế tạo anh hùng. Sự bùng nổ của trí tuệ nhân tạo, đặc biệt là sự xuất hiện của kiến trúc Transformer (nền tảng của ChatGPT), đã thay đổi tất cả. Các mô hình ngôn ngữ lớn hoạt động theo một cách khác hẳn so với trò chơi điện tử. Chúng là những cỗ máy ngốn dữ liệu điên cuồng, đòi hỏi phải nạp hàng trăm gigabyte tham số vào bộ xử lý chỉ trong một cái chớp mắt để tính toán câu trả lời tiếp theo. Lúc này, độ trễ thấp của GDDR trở nên vô nghĩa nếu con đường quá hẹp không thể tải hết lượng dữ liệu đó. Chỉ có siêu xa lộ 1024 làn xe của HBM mới đủ sức gánh vác trọng trách này.

Từ một kẻ bị hắt hủi vì đắt đỏ và thừa thãi, HBM bỗng chốc trở thành linh kiện quan trọng nhất, quyết định sự sống còn của các hệ thống AI. NVIDIA, kẻ từng chậm chân hơn AMD trong cuộc chơi HBM năm xưa, nay đã nhanh chóng gom trọn nguồn cung HBM toàn cầu để trang bị cho những con chip A100 và H100 của mình, biến chúng thành những cỗ máy in tiền thực thụ. Jensen Huang, CEO của NVIDIA, giờ đây không còn đắn đo về giá cả nữa; ông ta sẵn sàng trả bất cứ giá nào, thậm chí phải đi "năn nỉ" từng nhà máy của SK Hynix và Samsung để có đủ chip nhớ cho các đơn hàng đang xếp chồng chất.

Công nghệ đã được chứng minh, giải pháp đã quá rõ ràng, nhưng tại sao thế giới vẫn đang "khát" HBM đến mức tuyệt vọng như vậy? Tại sao chúng ta không đơn giản là xây thêm nhiều nhà máy để sản xuất chúng? Câu trả lời nằm ở sự phức tạp đến mức "điên rồ" trong quy trình chế tạo ra những tòa tháp silicon này, điều mà chúng ta sẽ cùng nhau bóc tách trong kỳ tiếp theo.

Bùi Tú

Nguồn Một Thế Giới : https://1thegioi.vn/vi-sao-hbm-la-cuu-tinh-don-duong-cho-ky-nguyen-ai-246087.html

Tin khác

Tin vui cho người mua iPhone 18 Pro

3 giờ trước

iPhone sẽ tăng giá?

3 giờ trước

iPhone 17e sẽ vô cùng hút người dùng vì nhiều lý do

một giờ trước

vivo X300 Max lộ diện: Xác nhận sạc nhanh 90W và cấu hình flagship Dimensity 9500

một giờ trước

Những bí ẩn cuối cùng của dòng Galaxy S26 trước ngày ra mắt

5 giờ trước

Huawei Pura X2 lộ diện với màn hình lớn hơn, chip Kirin 9030, camera 200MP

6 giờ trước