Trí tuệ nhân tạo đổi trục phát triển: Suy luận thời gian thực lên ngôi

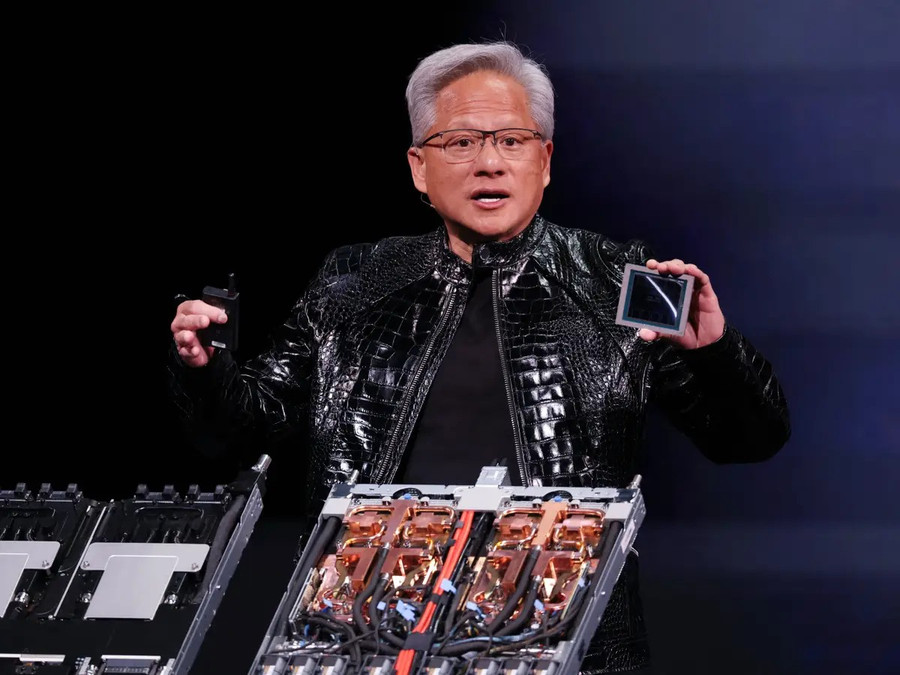

Jensen Huang - nhà sáng lập kiêm CEO của Nvidia. Ảnh: AFP

Thương vụ 20 tỷ USD giữa Nvidia và Groq phản ánh rõ bước ngoặt này, khi hạ tầng AI không còn chỉ xoay quanh GPU mà mở rộng sang các chip chuyên dụng cho tương tác trực tiếp.

Thương vụ trị giá 20 tỷ USD

Trong nhiều năm qua, sự trỗi dậy của Nvidia gần như gắn liền với một quan niệm quen thuộc: GPU chính là “động cơ” của trí tuệ nhân tạo (AI). Những con chip xử lý đồ họa này đã thúc đẩy làn sóng huấn luyện mô hình, đưa các mô hình ngôn ngữ lớn từ phòng thí nghiệm học thuật trở thành nền tảng cho những tham vọng công nghệ trị giá hàng nghìn tỷ USD. Tuy nhiên, thương vụ trị giá 20 tỷ USD giữa Nvidia và Groq cho thấy một thực tế mới: Giai đoạn tiếp theo của AI sẽ không còn do GPU quyết định một mình.

GPU (Graphics Processing Unit) vốn là bộ xử lý đồ họa, được thiết kế để xử lý các phép tính phức tạp và song song, phục vụ hiển thị hình ảnh trong game, video hay đồ họa 3D. Khả năng này cũng khiến GPU đặc biệt phù hợp cho việc huấn luyện các mô hình AI quy mô lớn. Nhưng khi AI bước ra khỏi phòng thí nghiệm để đi vào ứng dụng thực tế, nhu cầu đang dần thay đổi.

Groq theo đuổi một hướng đi khác, với loại chip chuyên biệt mang tên Bộ xử lý ngôn ngữ (LPU – Language Processing Unit). Ngành công nghiệp AI đang dịch chuyển trọng tâm từ “đào tạo mô hình” sang “vận hành mô hình” trong thế giới thực – giai đoạn mà AI trả lời câu hỏi, tạo hình ảnh hay trò chuyện trực tiếp với người dùng. Theo các phân tích gần đây của RBC Capital, mảng chip phục vụ suy luận và vận hành AI có thể sớm trở thành lĩnh vực chủ đạo, thậm chí vượt qua thị trường chip dùng cho huấn luyện trong tương lai.

Nếu huấn luyện AI giống như quá trình “xây dựng bộ não”, đòi hỏi sức mạnh tính toán khổng lồ và tính linh hoạt cao, thì vận hành AI lại đặt ra những ưu tiên khác. Lúc này, tốc độ phản hồi, tính ổn định, hiệu quả năng lượng và chi phí cho mỗi câu trả lời trở nên quan trọng hơn so với sức mạnh thô thuần túy. Đây chính là khoảng trống mà Groq nhắm tới.

Được thành lập bởi các cựu kỹ sư của Google, Groq phát triển các LPU với triết lý thiết kế khác biệt. Thay vì hoạt động như những “nhà máy đa năng” giống GPU, các LPU được ví như dây chuyền lắp ráp chính xác, nơi mỗi thao tác đã được lên kế hoạch sẵn, thực hiện theo một trình tự cố định và lặp lại nhất quán. Cách tiếp cận này giúp tối ưu tốc độ và hiệu suất cho các tác vụ suy luận AI theo thời gian thực - yếu tố ngày càng giữ vai trò then chốt trong kỷ nguyên AI tiếp theo.

Mới đây, Nvidia khẳng định công nghệ của hãng vẫn đang đi trước phần còn lại của ngành công nghiệp AI một thế hệ. Trong bài đăng chính thức, Nvidia cho rằng, các dòng chip của họ có ưu thế về tính linh hoạt và sức mạnh so với chip ASIC – những bộ xử lý chuyên dụng như TPU của Google, vốn thường được thiết kế cho một công ty hoặc một mục đích cụ thể.

Theo các nhà phân tích, Nvidia hiện nắm giữ hơn 90% thị phần chip AI nhờ các bộ xử lý đồ họa. Tuy vậy, trong thời gian gần đây, những con chip do Google tự phát triển lại thu hút sự quan tâm ngày càng lớn, được xem là phương án thay thế tiềm năng cho Blackwell – dòng GPU rất mạnh nhưng cũng có chi phí cao của Nvidia.

Khác với Nvidia, Google không bán chip TPU ra thị trường. Thay vào đó, hãng sử dụng TPU cho các nhu cầu nội bộ và cho phép doanh nghiệp thuê thông qua nền tảng Google Cloud. Đầu tháng này, Google đã ra mắt Gemini 3 - một mô hình AI tiên tiến, được đánh giá cao và được huấn luyện hoàn toàn trên TPU do chính Google phát triển, thay vì GPU của Nvidia.

Đại diện Google cho biết: “Chúng tôi đang chứng kiến nhu cầu tăng nhanh đối với cả TPU tùy chỉnh lẫn GPU của Nvidia. Google cam kết hỗ trợ cả hai nền tảng này, như đã làm trong nhiều năm qua”.

Về mặt kỹ thuật, GPU của Nvidia được thiết kế với mục tiêu linh hoạt tối đa. Chúng sử dụng các bộ lập lịch phức tạp và hệ thống bộ nhớ ngoài lớn để xử lý nhiều loại tác vụ khác nhau. Chính sự linh hoạt này giúp GPU thống trị thị trường huấn luyện AI trong suốt thời gian qua. Tuy nhiên, đi kèm với đó là chi phí cao và mức tiêu thụ năng lượng lớn – những yếu tố ngày càng trở nên nhạy cảm khi các sản phẩm AI bước vào giai đoạn vận hành ổn định.

“Khi ngành công nghiệp bán dẫn tiếp tục dịch chuyển, GPU đã giành chiến thắng rõ rệt trong làn sóng đầu tiên của trung tâm dữ liệu AI, đó là huấn luyện mô hình. Nhưng xét về thiết kế, GPU không được tối ưu hóa cho mọi giai đoạn”, Tony Fadell - cha đẻ của iPod và là nhà đầu tư vào Groq - nhận định. Quan điểm này cho thấy, dù GPU vẫn giữ vai trò trung tâm, cuộc đua chip AI đang dần mở sang một giai đoạn mới, nơi hiệu quả và tính chuyên biệt ngày càng được đặt lên hàng đầu.

Logo Nvidia hiển thị trên màn hình điện thoại thông minh. Ảnh: Reuters

Sự bùng nổ của các loại chip khác nhau

Các nhà phân tích của TD Cowen nhận định, việc Nvidia không chỉ tung ra một con chip chuyên dụng, mà còn theo đuổi cả một kiến trúc hoàn toàn mới cho thấy thị trường AI đã lớn mạnh và bước vào giai đoạn trưởng thành rõ rệt.

Trước đây, các khoản đầu tư hạ tầng AI chủ yếu xoay quanh nhu cầu huấn luyện mô hình. Khi đó, quan điểm phổ biến là “chip dùng để huấn luyện hôm nay sẽ trở thành công cụ suy luận ngày mai” – một lợi thế lớn cho GPU của Nvidia. Tuy nhiên, theo các chuyên gia, cách tiếp cận này đang dần không còn phù hợp.

Chris Lattner, một trong những gương mặt tiên phong của ngành - người từng tham gia phát triển phần mềm cho TPU của Google và đồng thiết kế chip AI cùng Jonathan Ross, nhà sáng lập Groq - cho rằng tương lai trung tâm dữ liệu AI sẽ chứng kiến sự bùng nổ của nhiều loại chip khác nhau.

“Thứ nhất, AI không phải là một khối lượng công việc duy nhất, mà bao gồm rất nhiều tác vụ khác nhau cho huấn luyện và suy luận. Thứ hai, việc chuyên môn hóa phần cứng mang lại lợi ích rất lớn về hiệu quả”, Chris Lattner phân tích và nhấn mạnh, xu hướng “thoát khỏi sự chi phối tuyệt đối của GPU” đang được củng cố thêm chính bởi thương vụ Nvidia mua lại Groq.

Thực tế, ngày càng nhiều công ty tìm cách giảm phụ thuộc vào GPU. Năm 2024, Cerebras gây chú ý khi phát triển những con chip AI khổng lồ, được tối ưu cho tốc độ, với băng thông bộ nhớ được quảng bá là cao hơn hàng nghìn lần so với GPU hàng đầu của Nvidia khi đó.

Google thiết kế TPU để xử lý hiệu quả các tác vụ AI tùy chỉnh với tốc độ rất cao, trong khi Amazon cũng có chip suy luận riêng mang tên Inferentia. Bên cạnh đó, các startup như Positron AI cho rằng họ có thể đạt hiệu năng suy luận ngang bằng, thậm chí vượt Nvidia, nhưng với chi phí thấp hơn đáng kể.

Trong bối cảnh đó, thỏa thuận giữa Nvidia và Groq có thể được xem như một nước đi “đón đầu”. Thay vì để các đối thủ và chuyên gia công nghệ từng bước làm suy yếu vị thế thống trị của GPU, Nvidia đã chủ động chọn một hướng tiếp cận khác, nhằm thích nghi với giai đoạn mới của cuộc đua chip AI.

Theo Bloomberg, các mô hình AI tập trung vào suy luận được đánh giá là mang lại hiệu quả kinh tế cao hơn, đặc biệt trong bối cảnh từ năm 2026, trí tuệ nhân tạo sẽ thâm nhập sâu vào hầu hết các lĩnh vực của đời sống và kinh tế.

“Đây là giai đoạn then chốt để kiểm chứng liệu hàng trăm tỷ USD đã đổ vào các trung tâm dữ liệu có thực sự tạo ra giá trị hay không. Nếu suy luận không trở thành trọng tâm, thì phần lớn các khoản đầu tư vào AI sẽ khó mang lại lợi nhuận”, ông Matt Garman - CEO Amazon Web Services, nhận định.

Điểm đáng chú ý là Nvidia không đặt cược vào một “người chiến thắng” duy nhất. GPU vẫn giữ vai trò chủ lực trong huấn luyện mô hình và các tác vụ cần tính linh hoạt cao, trong khi những con chip chuyên dụng như của Groq được kỳ vọng đảm nhiệm suy luận nhanh, theo thời gian thực.

Lợi thế cốt lõi của Nvidia nằm ở khả năng kết nối các mảnh ghép này thông qua phần mềm, hạ tầng mạng và hệ sinh thái nhà phát triển, giúp nhiều loại phần cứng khác nhau có thể phối hợp trơn tru.

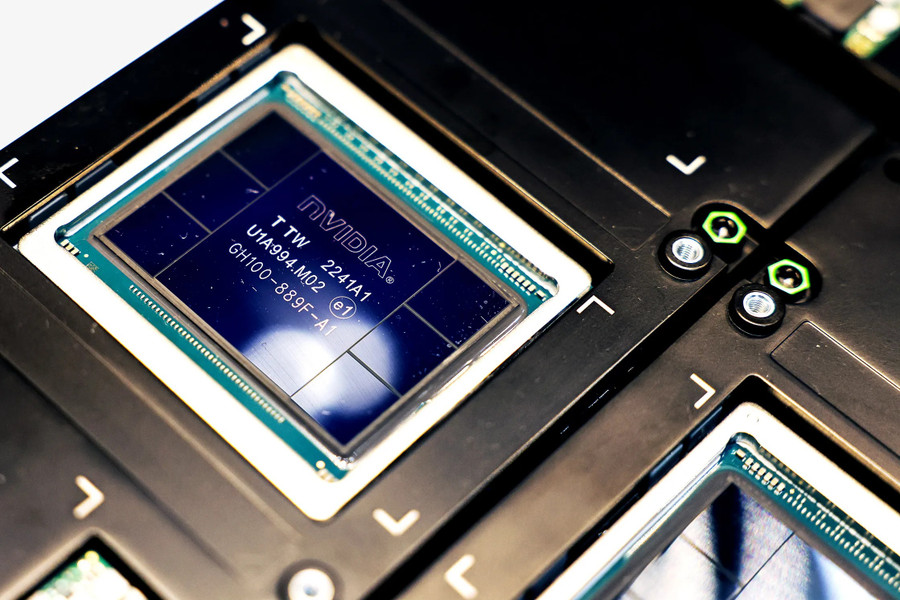

Bộ xử lý đồ họa (GPU) HGX H100 – nền tảng cho siêu máy tính trí tuệ nhân tạo của Nvidia. Ảnh: Bloomberg

“Các trung tâm dữ liệu AI đang dần trở thành môi trường lai, nơi GPU và các ASIC tùy chỉnh hoạt động song song, mỗi loại được tối ưu cho những khối lượng công việc khác nhau”, các nhà phân tích của RBC nhận định trong một báo cáo gần đây, khi đề cập đến các mạch tích hợp chuyên dụng như LPU của Groq.

Xung quanh thương vụ này, cũng tồn tại những góc nhìn trái chiều. Một số đối thủ cho rằng đây là bằng chứng cho thấy GPU không còn phù hợp với các tác vụ suy luận tốc độ cao. Ngược lại, nhiều ý kiến xem đây là sự xác nhận cho một tương lai “phân mảnh”, nơi mỗi loại chip đảm nhiệm một vai trò riêng.

Bằng cách cấp phép công nghệ của Groq và tích hợp đội ngũ này vào hệ sinh thái của mình, Nvidia đang tìm cách đảm bảo rằng họ không chỉ bán từng con chip, mà còn cung cấp trọn bộ “công cụ và dây chuyền lắp ráp” cho kỷ nguyên AI.

Thương vụ trị giá 20 tỷ USD giữa Nvidia và Groq được xem như một sự thừa nhận rõ ràng rằng, giai đoạn phát triển tiếp theo của trí tuệ nhân tạo sẽ không còn chỉ xoay quanh GPU. Nvidia, dưới sự dẫn dắt của Jensen Huang, vẫn đang giữ vị thế thống trị trong lĩnh vực phần cứng AI, nhưng động thái này cho thấy những dịch chuyển quan trọng của ngành đang đến rất gần.

Theo đánh giá của giới phân tích, ngành công nghiệp AI đang dần chuyển trọng tâm từ huấn luyện (training) sang ứng dụng trong thế giới thực. Sau khi mô hình được huấn luyện, giá trị thực sự của AI nằm ở khả năng trả lời câu hỏi, tạo hình ảnh hay trò chuyện với người dùng – quá trình này được gọi là suy luận (inference). RBC Capital cho rằng, suy luận đang nổi lên như nhiệm vụ trung tâm của điện toán AI và trong tương lai có thể vượt qua, thậm chí làm lu mờ vai trò của thị trường huấn luyện thuần túy.

Theo Business Insider

Trọng Dương

Nguồn GD&TĐ : https://giaoducthoidai.vn/tri-tue-nhan-tao-doi-truc-phat-trien-suy-luan-thoi-gian-thuc-len-ngoi-post765865.html

Tin khác

Tỷ phú Elon Musk ưu tiên dự án thành phố trên Mặt Trăng thay vì trên Sao Hỏa

5 giờ trước

Apple đứng ngoài cuộc đua 'đốt tiền'

một giờ trước

Điện thoại Android cũ thành 'miếng mồi' cho mã độc, Google khuyên đổi máy

một giờ trước

Các trung tâm dữ liệu sắp được đưa lên không gian?

2 giờ trước

Người dân có thể 'xóa' xe đã bán hay cho tặng qua VNeTraffic

2 giờ trước

Công an cảnh báo 17 tiện ích độc hại đã lừa hơn 840.000 người dùng, cần gỡ bỏ ngay lập tức

4 giờ trước